Gesammelte Praxiserfahrung

Search Engine Optimization Expert und Data Analytics

Tagesgeschäft als SEO und Projektmanager zwischen Trello, Teams und Analysetools

Im Rahmen der täglichen Analysen und monatlichen Reportings, arbeite ich, ergänzend zu den hier aufgeführten Einblicken, natürlich regelmäßig auch mit den Pflichttools eines jeden SEOs - Google Search Console im Frontend statt über API in KNIME, Looker Studio Reportings mit Anbindungen aus Sistrix, SE Ranking und Sheets für Betrachtungen der wichtigsten Metriken, Termlabs.io für Identifikation von OnPage Content Potential und natürlich Keywordplanner, Google Trends, Quaro, ChatGPT und andere Keyword Recherche Tools. Ich habe im Folgenden aber bewusst nur einige Ausschnitte zusammengestellt, die sich vermutlich von der breiten Masse und dem breiten Vorgehen etwas abgrenzen und nur einem kleineren Kreis geläufig sind. Für größere SEO Audits kommen auch Tools wie PageSpeed Insights, Lighthouse und webpagetest.org zum Einsatz, damit ergänzend zu den Entwicklertools möglichst umfassend technische Fehler zu Core Web Vitals aufgezeigt werden können. Natürlich unter Berücksichtigung, welche ChromeUX Report Daten überhaupt vorliegen und welche Fehler sich auf Lab-Daten beziehen. Das hilft den Ansprechpartnern, es möglichst unkompliziert an den Entwickler weiterzuleiten, der direkt versteht was umgesetzt werden muss. Denn einfach nur mitteilen, dass Fehler vorliegen, hilft den wenigsten Kunden.

In meiner Freizeit versuche ich mich aber auch in Themen weiterzubilden, die mich ebenfalls sehr interessieren und diese, insofern es sich anbietet, in meinem Tagesgeschäft einzubinden. Als wöchentlich wechselnd alleinerziehender Vater, komme ich hier allerdings nicht so rasch voran, wie ich es mir wünschen würde, besonders ohne Mentor und konkrete Projekte. Doch gerne gebe ich einen Einblick in meine erworbenen Kurse, die noch ausstehen:

- PHP: Der ultimative Kurs für Webentwicklung mit PHP, Stand: Kapitel 164/295 = 56%

- Python Bootcamp: Vom Anfänger zum Profi inklusive Data Science - Python komplett: Grundlagen, Webapps, Crawler, Numpy, Pandas, Module, OOP, IO, Machine Learning, Deep Learning,etc., Stand: Ausstehend

- Der ultimative Python-Kurs für Data Science, ML & AI: Ohne Vorkenntnisse in 4 Schritten systematisch mit Python zum Data Scientist. Inkl. Deep Learning, Machine Learning & KI, Stand: Ausstehend

- Lerne Python und automatisiere deinen Alltag (und Job): Lerne Python am Beispiel von unzähligen, praxisorientierten Projekten. Schritt für Schritt zum Python-Profi, Stand: Ausstehend

- Deep Learning, Neuronale Netze und AI: Der Komplettkurs mit Python, Keras und Tensorflow 2: Erkenne Bilder, sage den Bitcoin-Kurs vorher & schreibe eine AI!, Stand: Ausstehend

- Ethical Hacking mit Python in der Praxis: Werde White Hat Hacker: Lerne PenTesting, Password Cracking, Network Hacking, Kali Linux, Keylogger, Man-in-the-Middle, etc.", Stand: Ausstehend

- R Komplett: Data Science, Machine Learning & Neuronale Netze - R vom Anfänger zum Profi: Vektoren, Data Frames, CSV-Dateien verarbeiten, Web-Crawling, Neuronale Netze,etc., Stand: Ausstehend

- Machine Learning von A-Z: Lerne Python & R für Data Science - Maschinelles Lernen komplett: Regression, Klassifizierung, Clustering, NLP, AI, KI, Deep Learning & Neuronale Netze, Stand: Ausstehend

- C++ Bootcamp: Vom Anfänger zum C++ - Entwickler - Die Schritt-für-Schritt - Anleitung für die Programmiersprache C++. Inklusive vielen Beispielen & Übungen, Stand: Ausstehend

- Fortgeschrittenes CSS: Animationen, Flexbox, SVG, 3D, SASS, etc. - Vom Anfänger zum HTML & CSS-Profi: Mit einem riesigen Praxisprojekt, Stand: Ausstehend

Ich nehme an dieser Einblick in mein gebuchtes und ausstehendes Portfolio vermittelt einen ungefähren Einblick in meine Interessen und Begesiterung für Themen rund um Webentwicklung und Data Science, die ich auch als Basis für hervorragendes Technisches SEO verstehe. Indexierungsanalysen, OnPage Faktoren und Content-GAPs lassen sich natürlich ohne tieferes technisches Verständnis lösen. Allerdings kommen bei größeren Projekten auch stetig Fragestellungen ins Spiel, die sich auf die Technik, Frameworks, konkrete Core Web Vital Optimierungen des INP, LCP, etc. beziehen. Hier helfen zum Teil auch Entwicklertools im Browser und Tools wie webpagetest.org nur bis zu einem gewissen Punkt weiter, wenn das tiefergehende technische Verständnis fehlt.

Ein klassisches, einfaches und greifbares Praxis-Beispiel: Kundenfrage: Wird mein Content überhaupt von Google eingelesen oder abgestraft, wenn dieser hinter einem Tab, der geklickt werden muss verborgen ist? Google klickt ja bekanntlich nicht.

Richtige Antwort: Mittels Display:none wird per CSS der Content ausgeblendet, ist aber für den Googlebot selbstverständlich auf der Seite zugänglich. Und gerade in Zeiten von mobile-first sind CSS Elemente für eine optimierte Ansicht und leichte Bedienbarkeit wichtig. Selbstverständlich versteht Google aber auch, dass der Default abgebildete Teil etwas wertvoller ist, als der versteckte - jedoch nicht in dem Maße, dass dieser irrelevant wird. Solche technischen Grundlagen werden verständlich, wenn man sich mit HTML, CSS und JavaScript auseinander setzt. Und gerade das sind Fragestellungen, die mich interessieren und antreiben, mich auch privat stets weiterzubilden.

ChatGPT und Google sind cool - aber unabhängiges Denken ist noch viel cooler!

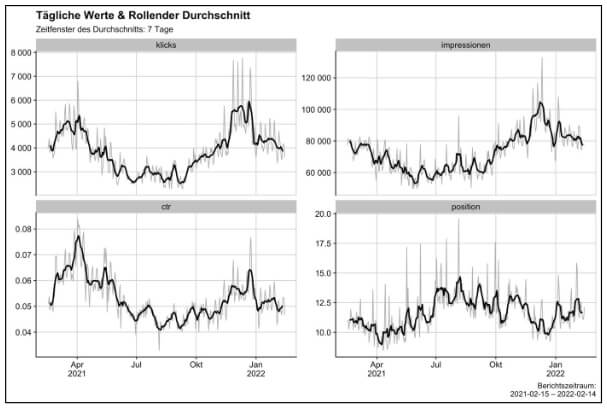

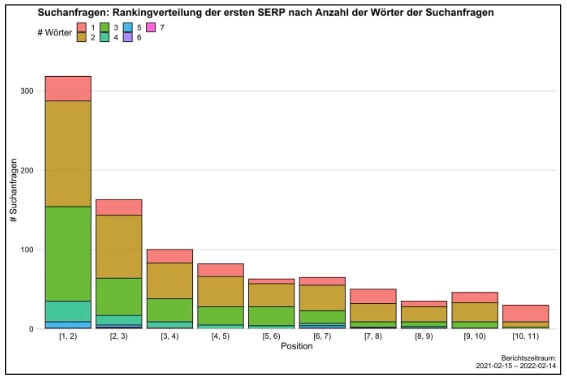

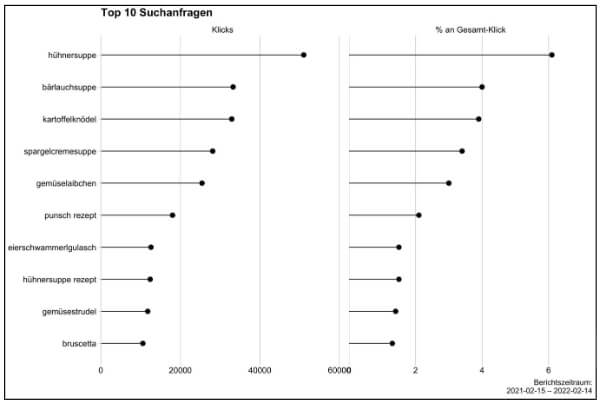

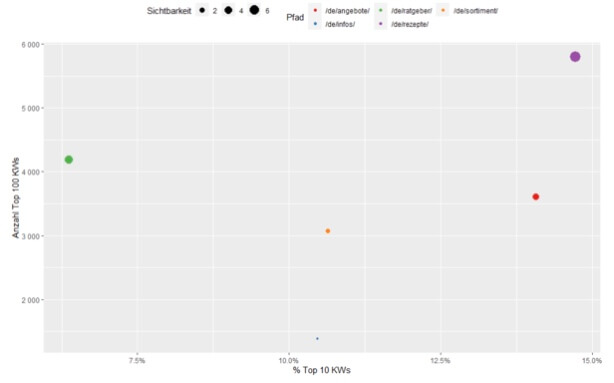

Data Science mit R

Bereits meine Bachelorarbeit drehte sich um das Thema R. Hintergrund war die Fragestellung, welches Thema die SEO-Welt aus Sicht der damaligen Zeit in den nächsten Jahren beschäftigen wird und ein eher anspruchsvolleres Thema ist. Im persönlichen Gespräch mit meinem Mentor Prof. Dr. Mario Fischer kamen wir auf das Problem zu sprechen, dass die Datenmangen immer größer werden, die Plattformen auch in der Zahl steigen und ein Datenhandling zum Aufbereiten für Reportings mit Excel einfach ineffizient - teilweise unmöglich wird, sobald Datenmangen in Excel Millionen von Zeilen und hunderte Spalten überschreiten. Eine hervorragende Lösung hierfür ist R. Als Statisiksoftware und kostenlos verfügbar, noch aus den 90er Jahren.

R ließt Variablen Vectorbasiert ein, läuft auf jedem Betriebssystem und kann um Erweiterungspakete für nahezu jede statistische Fragestellung erweitert werden. Und genau das macht R so wertvoll und leistungsfähig. Dank RStudio mittlerweile auch ansehnlich. On Top hat R den hervorragenden Bonus, dass es fantastische Diagramme erzeugen kann wie kaum ein Tool, insofern man nur das jeweilige Paket installiert und im Script einbindet. Ich muss allerdings betonen, auch wenn mich das Thema R - genau wie Python wahnsinnig interessiert, ist es mir bisher zeitlich und ohne Mentor nicht möglich mich dort eigenständig als Entwickler weiterzuentwickeln. Ich verfolge Fachartikel, habe udemy Kurse zu R, Python und Data Science erworben, bin aber in der Praxis bisher begrenzt auf die Anwendung bereitgestellter Scripte, da mir die Zeit fehlt autodidaktisch innerhalb meiner Projekte für reale Anwendungsszenarien zu entwickeln. Aber mein Interesse dafür besteht in jedem Fall.

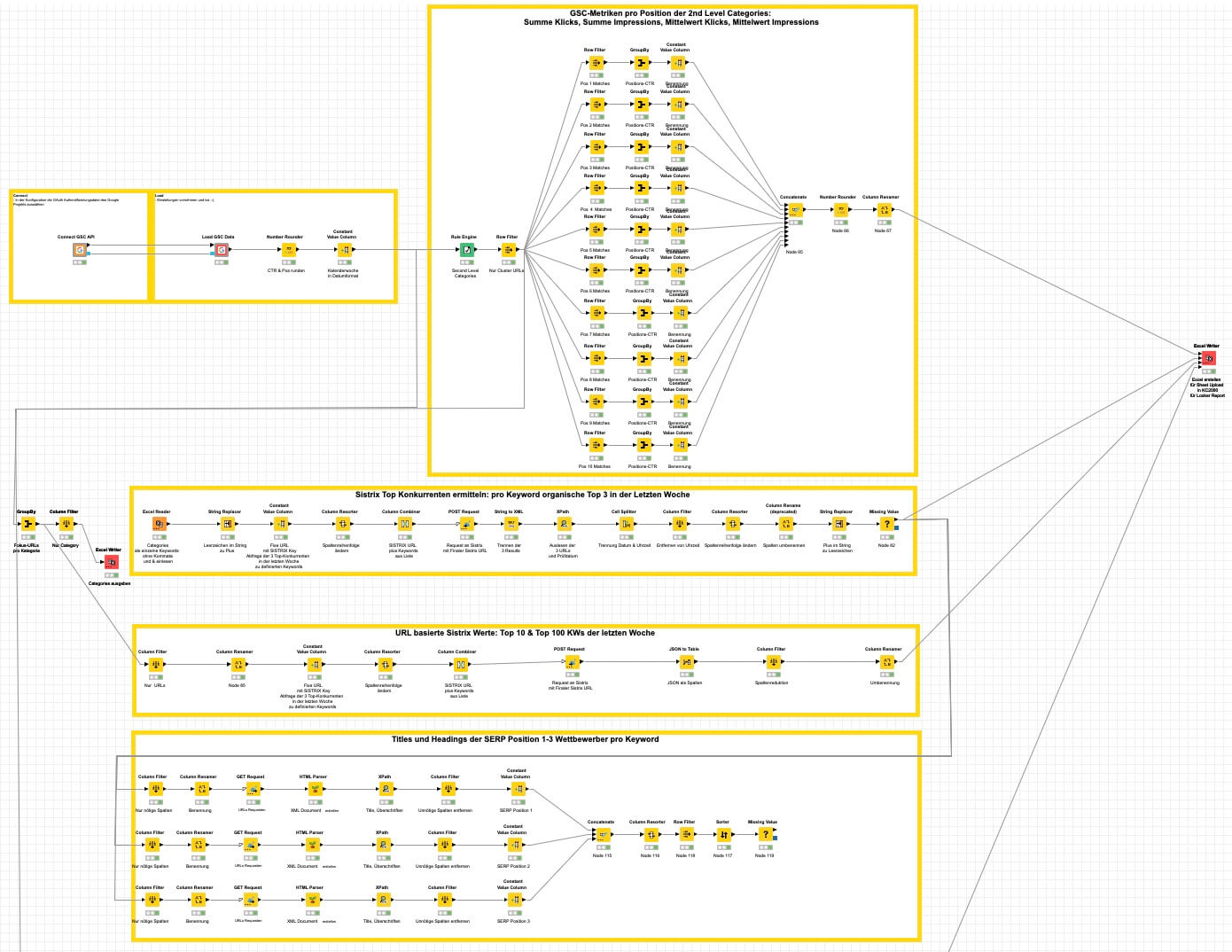

Data Science mit KNIME

Im Rahmen der täglichen Analysen zu immer größer werdenden Datenmengen, sucht man früher oder später effizientere Wege als Excel - gerade um Zeitfresser zu automatisieren. Ein Tool, das keine Programmierkenntnisse erfodert und einen relativ leichten Einstieg bietet ist KNIME. Der großer Vorteil ist die OpenSource, große Community, extreme Leistungsfähigkeit und vor allem die Möglichkeit auf die meisten Tools unkompliziert zugreifen zu können. Mittlerweile gibt es Nodes für Zugriffe auf GSC, Google Analytics, Sheets, Ryte, etc. Zudem findet man mittlerweile regelmäßig Vorträge und Fachartikel in der Website Boosting zu Workflows, die den Alltag effizienter gestalten. Bereits 2021 habe ich begonnen, mich mit dem Tool auseinander zu setzen und auch meine Einführung bei Johannes Kunze und Patrick Lürwer in einem Workshop erhalten. Seither nutze ich das Tool täglich und erweitere die Anwendungsgebiete je nach Herausforderung. Auch das unkomplizierte Teilen von Workflows, macht KNIME wertvoll für Teams im Umgang mit großen Datenmengen. Aus diesem Grund wurde bereits eine interne Schulung von mir zur Weiterbildung der Kollegen gehalten.

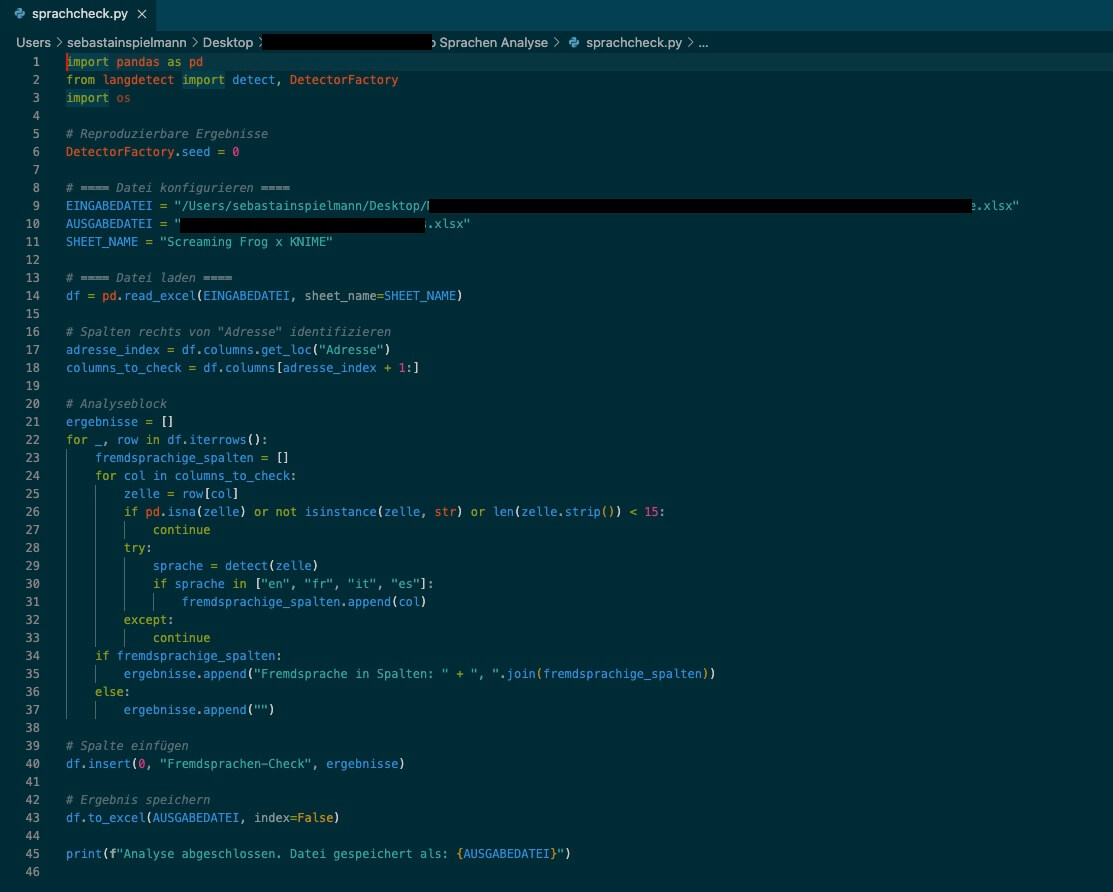

Python Scripte in Visual Studio Code

Spätestens seit ChatGPT auch PythonScripte liefert, kann man auch auf diesem Wege seine Analysen effizienter gestalten. Hier ist ein PythonScript aus Visual Studio Code zu sehen, das von ChatGPT erstellt wurde. Vorangegangen ist ein ScreamingFrog Crawl mit Custom Extractioin aller Content-Felder und der Breadcrumb, da bei diesem international auf mehreren Domeins vertretenem Kunden, immer wieder in Analysen falsche Sprachen in einer Produktbeschreibung, einem Heading oder der Breadcrumb aufgefallen sind. Leider ist eine endgültig manuelle Überprüfung noch notwendig. Denn "Jobs" auf einer deutschen Domain ist keine falsche Sprache, ebenso wie GROßBUCHSTABEN. Doch in jedem Fall ist es effizienter, als jede URL auf ihre Contentspalten manuell zu untersuchen. Diese Voranalyse hilft immens.

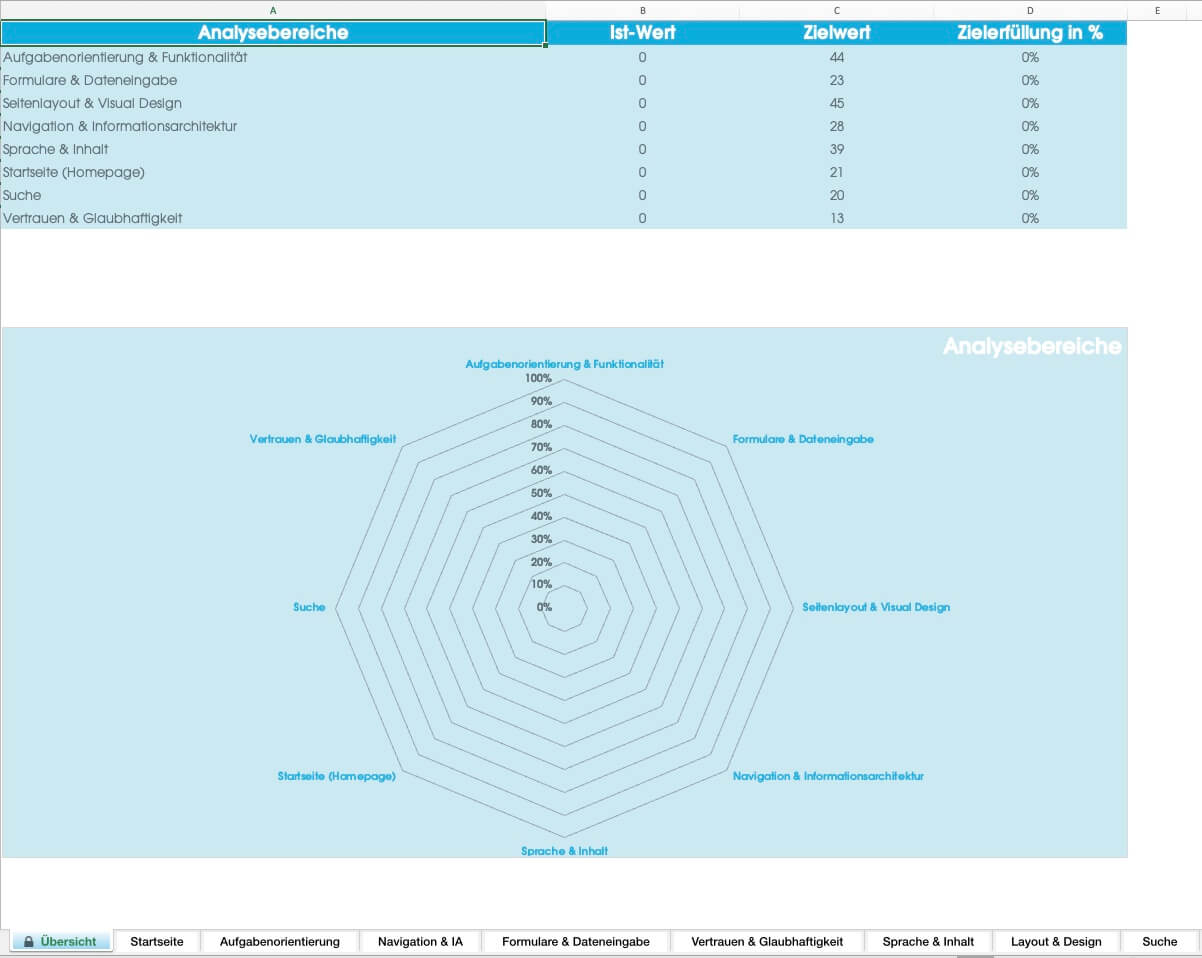

Usability und UX Check einer Website mit Potential für Konversiontreiber

Bereits im Studium gab es Schwerpunkte auf die Themen Usability und Oberflächengestaltung mit einducksvollen Experimenten und psychologischen Trigger-Effekten, um Nutzer zum Kaufen oder Vertrauen auf einer Website zu animieren. Vielen fallen dabei sofort Trigger-Elemente der Verknappung ein oder die berühmten Sternebewertungen mit dutzenden Nutzerberichten, die Social Proof genannt werden. Doch auch eine Breadcrumb, eine Suchfunktion, Trust-Elemente, Schriftarten und -größen, Bilder, Navigation, Farben und viele weitere Dinge spielen eine wichtige Rolle beim Zielpublikum. In diesem selbst aufbereiteten Katalog sind Hunderte Punkte, die manuell abgeprüft werden pro Website, um Potentiale für Konversionen zu ermitteln und Hindernisse aus dem Funnel zu beseitigen. Auch A/B-Testing spielt im Anschluss eine große Rolle. Basis dieses Katalogs bilden Recherchen zu Literatur von Astrid Kramer und Sara Weitnauer.

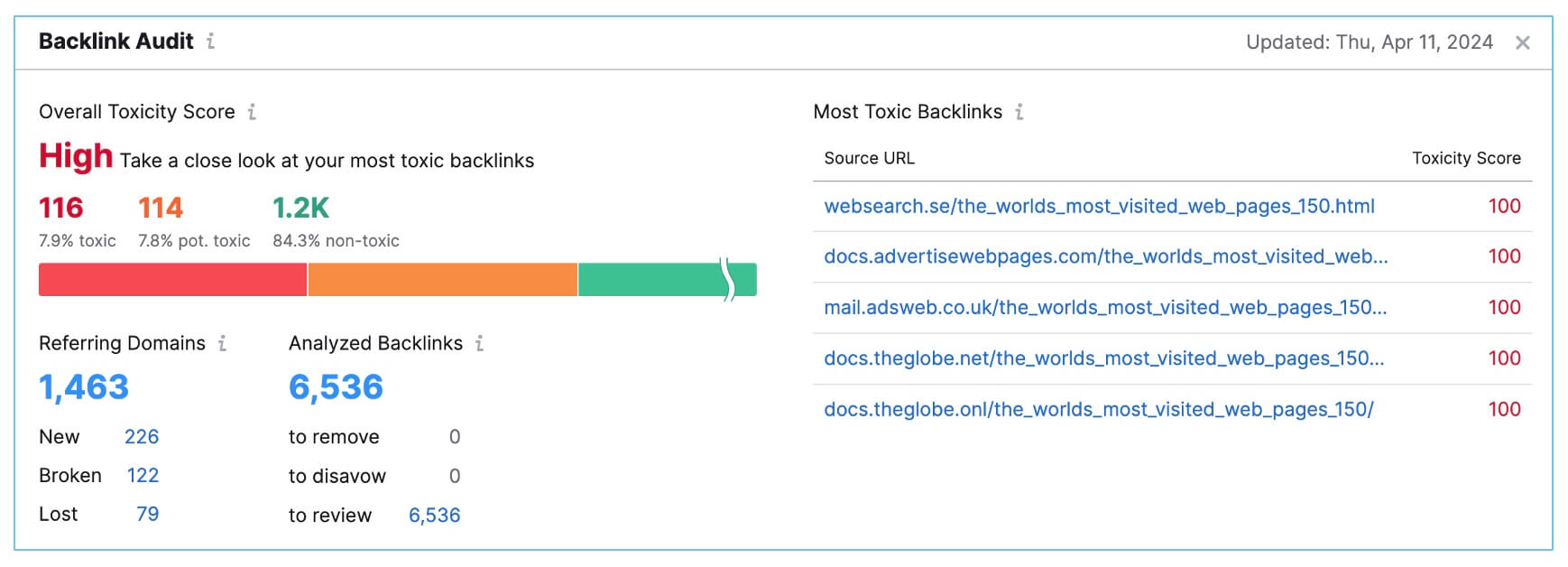

Backlink Toxicity Analysen mittels SEMRush (und Ahrefs)

Im Rahmen von SEO AUDITs oder der SEO Betreuung großer Domains, ist auch der OffPage Bereich ein wesentlicher Teil einer gesunden Domain. Um einer Website nicht zu viel negative Reputation zu verschaffen, was auch unter Black Hat SEO Techniken bekannt ist, sollte regelmäßig eine Backlink Toxicity Analyse erfolgen. Im Anschluss wird per Disavow-File in der Google Search Console an Google gemeldet, welche Verlinkungen zur eigenen Website entwertet werden sollen. Hier handelt sich es meist um Porn- oder Spam-Sites, die im Rahmen einer solchen Toxicity Audit entwertet werden.

Marketplaces Management mit Schwerpunkt Amazon im Praxissemester

Amazon SEO Strategie

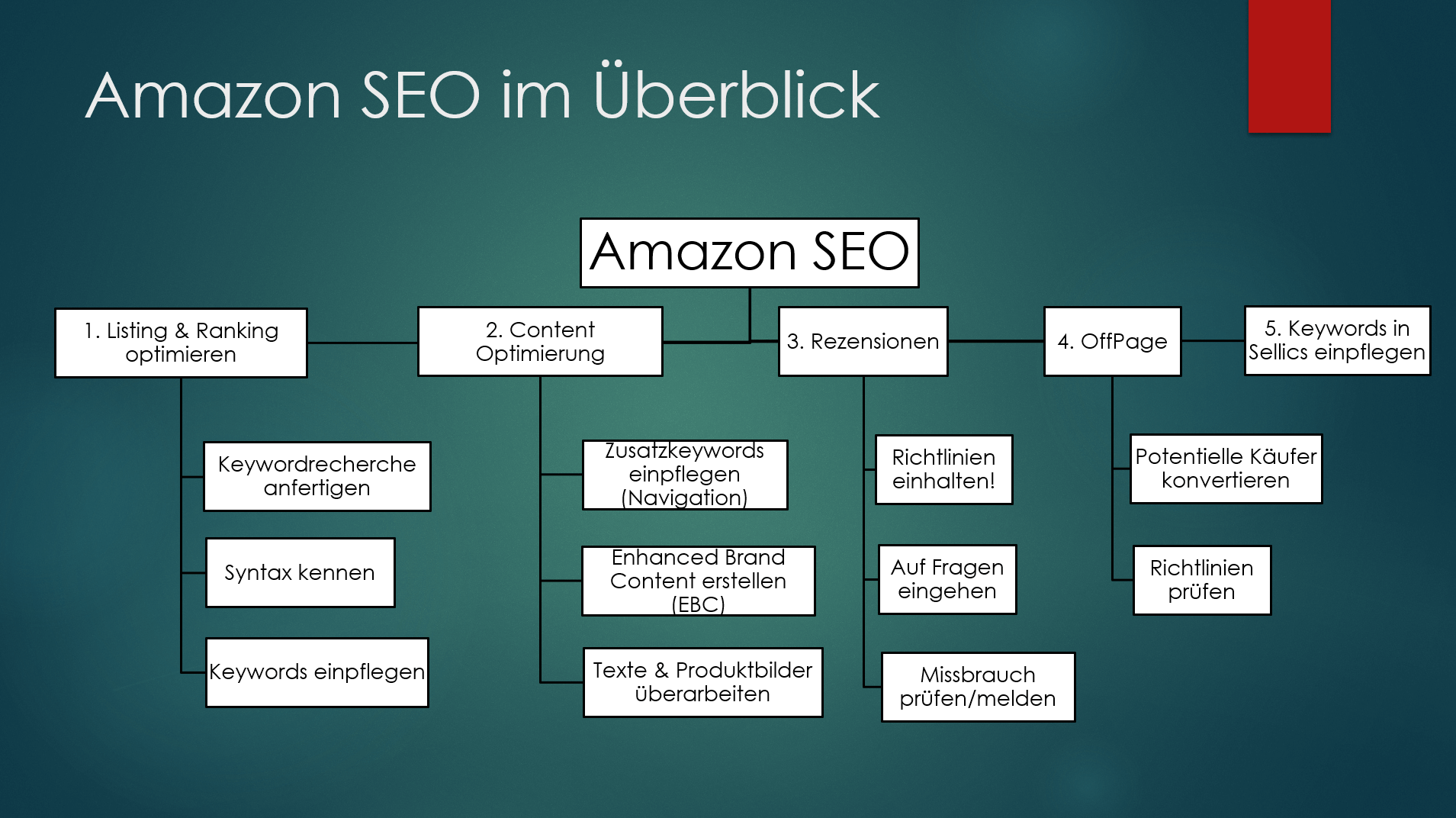

Im Rahmen des Marketplaces Managements als Professional Seller auf Amazon, gibt beiliegendes Diagramm aus meinem Praxissemester einen kurzen Überblick zu den Aufgaben, die ich eigenständig umgesetzt habe, um den Auftritt auf Amazon zu optimieren.

Amazon Sellercentral

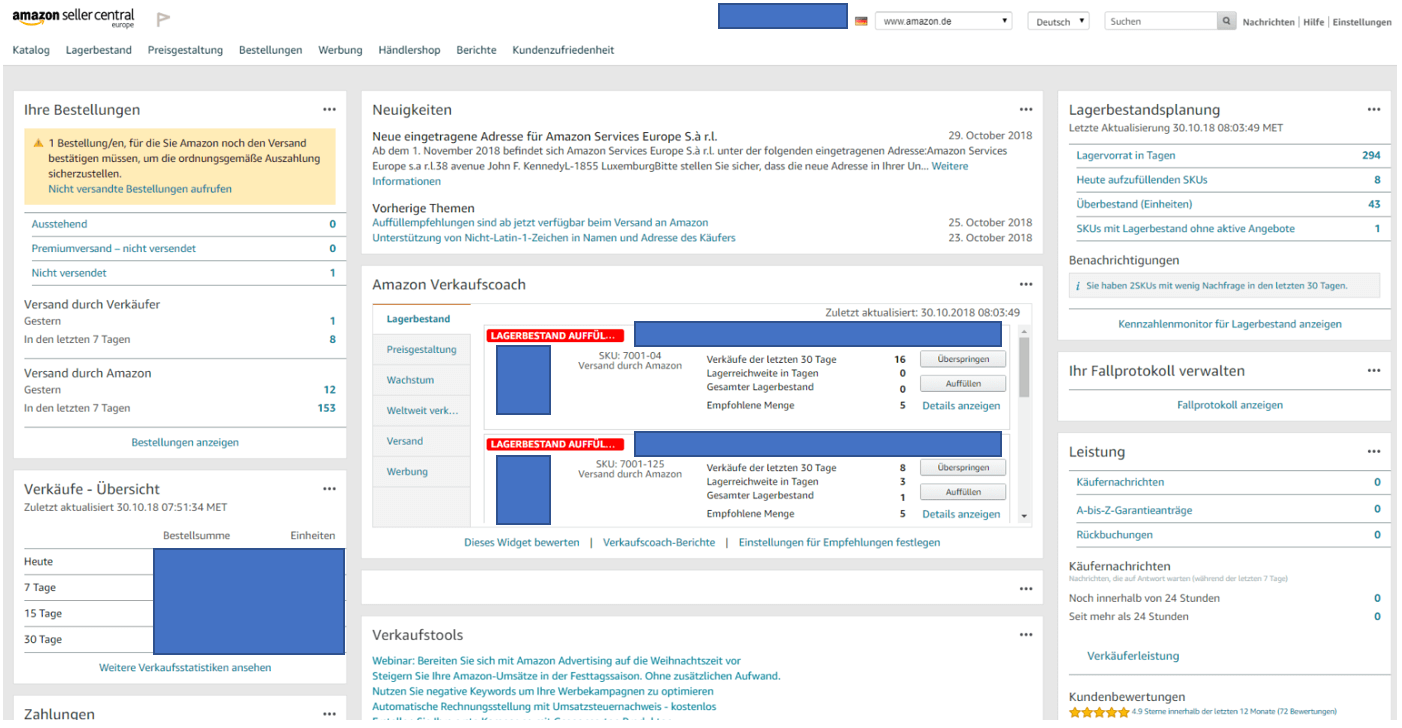

Zur Betreuung eines Professional Seller Accounts auf Amazon, war die Handhabung und Betreuung des Accounts auf Sellercentral das "täglich Brot". Die Aufgaben hier umfassten Nachlieferungen, Remissionen, Preisanpassungen, Benchmarking der Konkurrenz und natürlich Kundenrezensionen, um das Tagesgeschäft zu gewährleisten.

Sellics

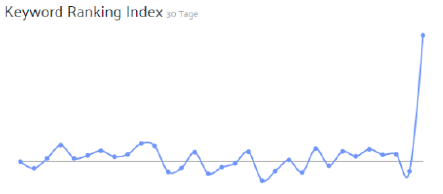

Gemäß dem Grundsatz "Keine Optimierungen ohne Messbarkeit", habe ich im Rahmen des Marketplaces Management auch mit dem Tool Sellics Erfahrungen sammeln können, um ein Monitoring meiner angefertigten Keywordoptimierungen zu gewährleisten und Erfolge, wie hier aus dem Auszug des Keyword Ranking Index, nachweisen zu können.Praxiserfahrung aus dem SEO-Bereich als Student

Keywordrecherchen mit dem KWFinder

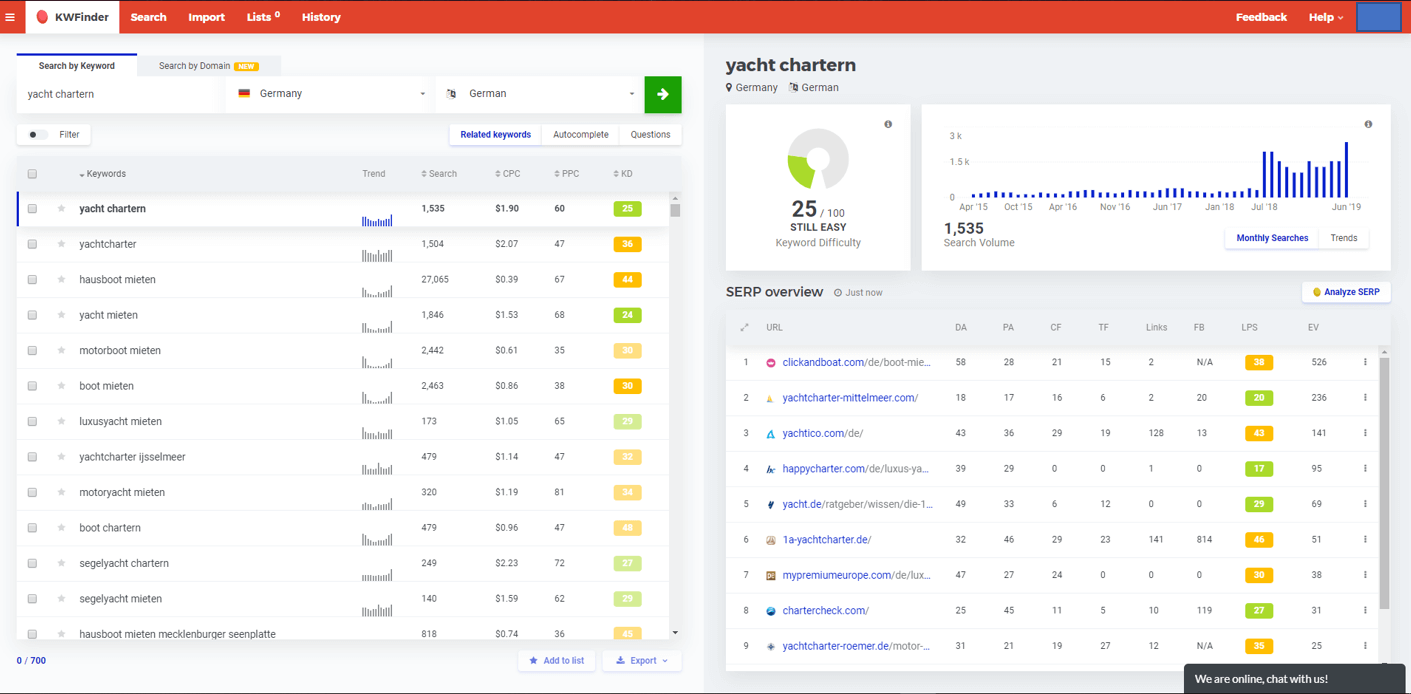

Neben dem sehr verbreiteten Google Keywordplanner, habe ich zudem auch mit dem Tool KWFinder von Mangools die Großzahl meiner Keywordrecherchen angefertigt. Nach Export als CSV-Datei, wurden anschließend die Daten aufbereitet und mit Excel weiterverarbeitet.

Keywordanalysen

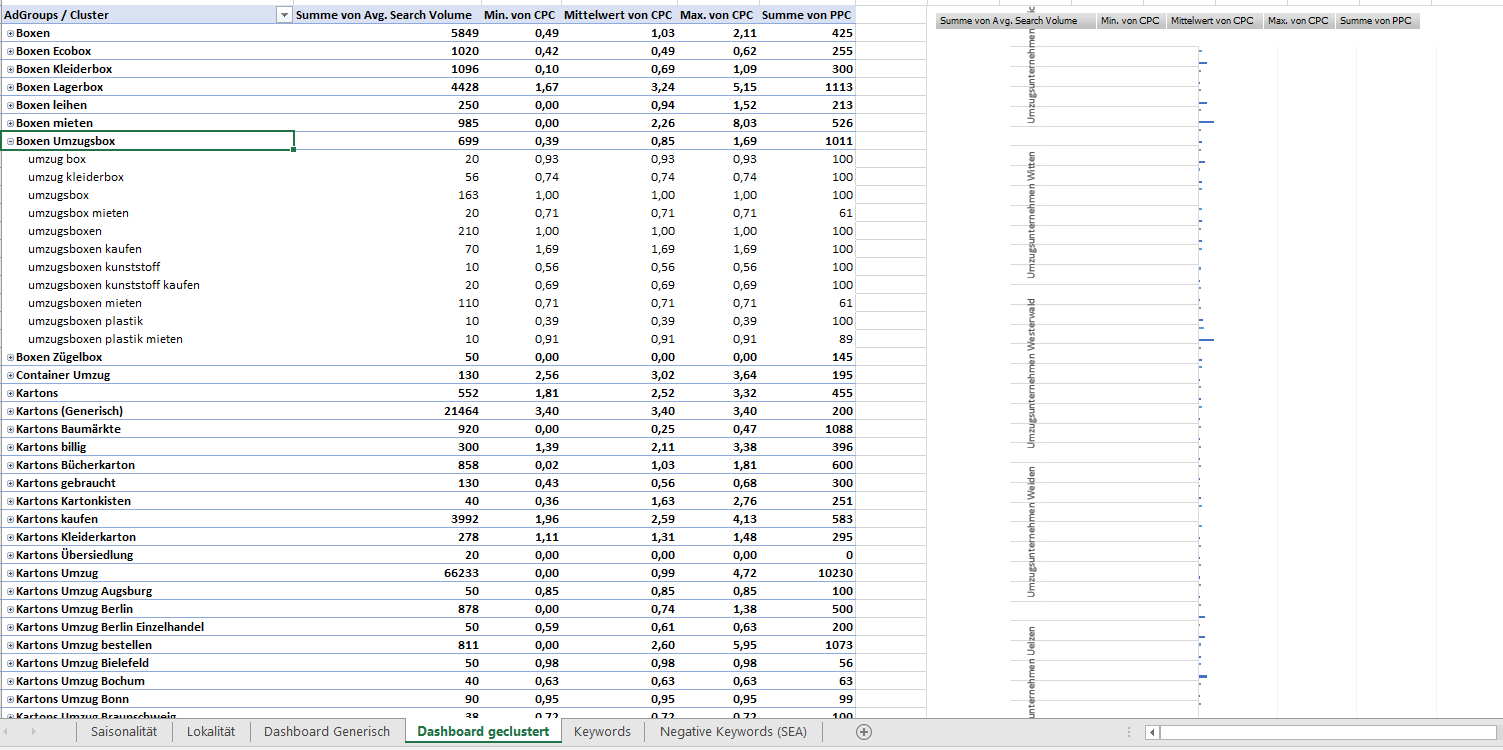

Aus den aufbereiteten Rohdaten der Keywordrecherche, wurden anschließend im Rahmen der Keywordanalyse Pivottabellen und grafische Visualisierungen von mir erstellt, um Suchvolumen, CPC und PPC zu relevanten Keywords übersichtlich aufzuzeigen und bereits negative Keywords (interessant für das SEA-Team) für eine bessere Budgetsteuerung bei Google Ads zu benennen.

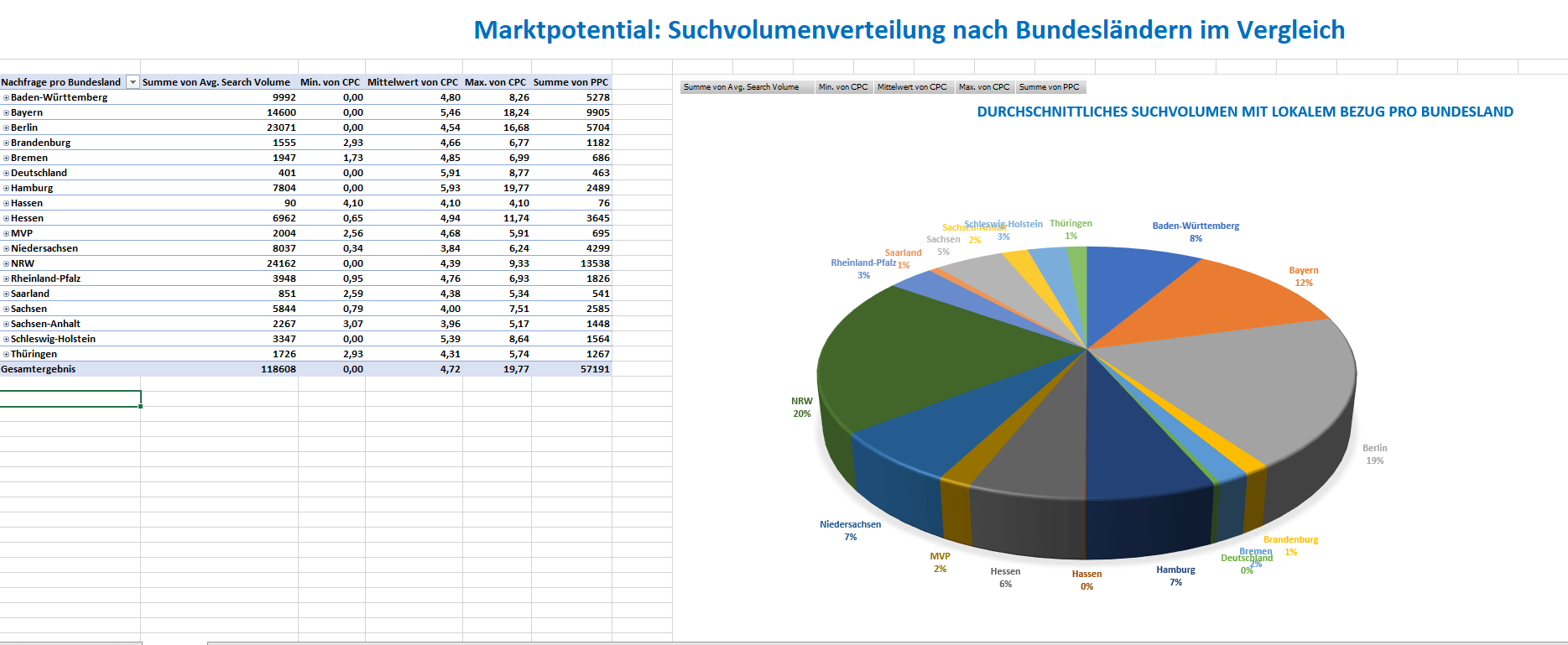

Local SEO Strategien

Auch local SEO Erkenntnisse der Keywordanalyse, die wie in diesem expliziten Fall, Standortpotentiale aufzeigen sollten für eine Expansion des Unternehmens, wurden von mir ermittelt und visualisiert.

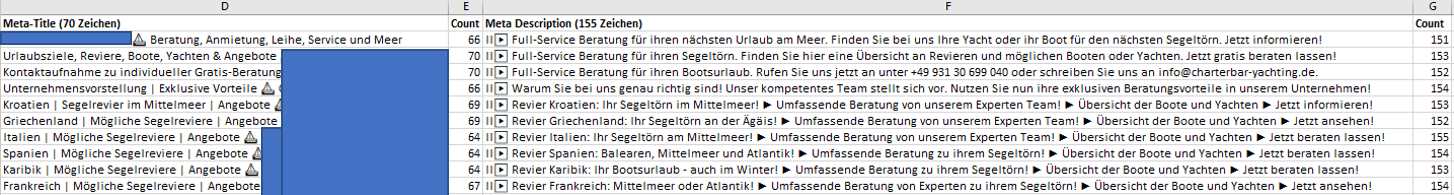

Meta-Titles und Description-Tags

Im Rahmen der SEO-Maßnahmen während der Projektarbeit, führte ich unter anderem auch die Überarbeitungen von Meta-Titles und Description-Tags zur Verbesserung der CR/CTR in den Suchergebnissen auf Google durch.

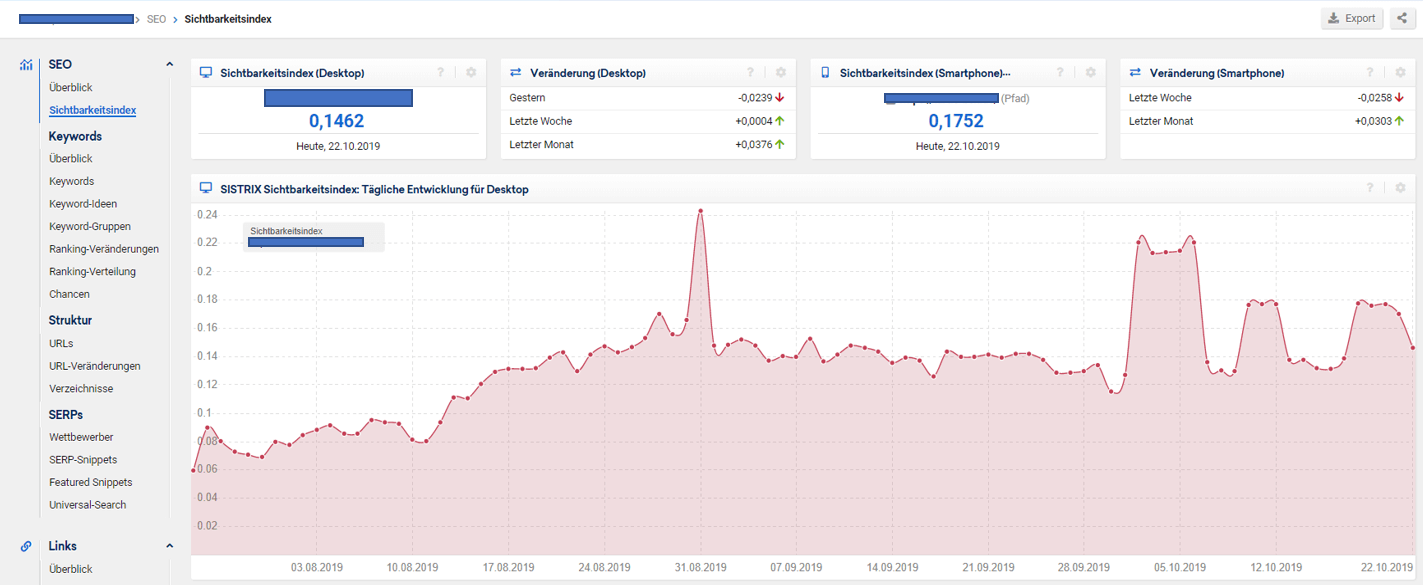

Sistrix

Im Rahmen meiner Tätigkeit als SEO-Werksstudent in einer Agentur und auch der Online-Marketing-Challenge während der zweiten Vertiefung, habe ich ebenfalls mit dem Tool Sistrix Erfahrung sammeln können und vor allem den Sichtbarkeitsindex geprüft, um den Erfolg betreuter Websites im Auge zu behalten sowie Benchmarking der Wettbewerber zu betreiben.

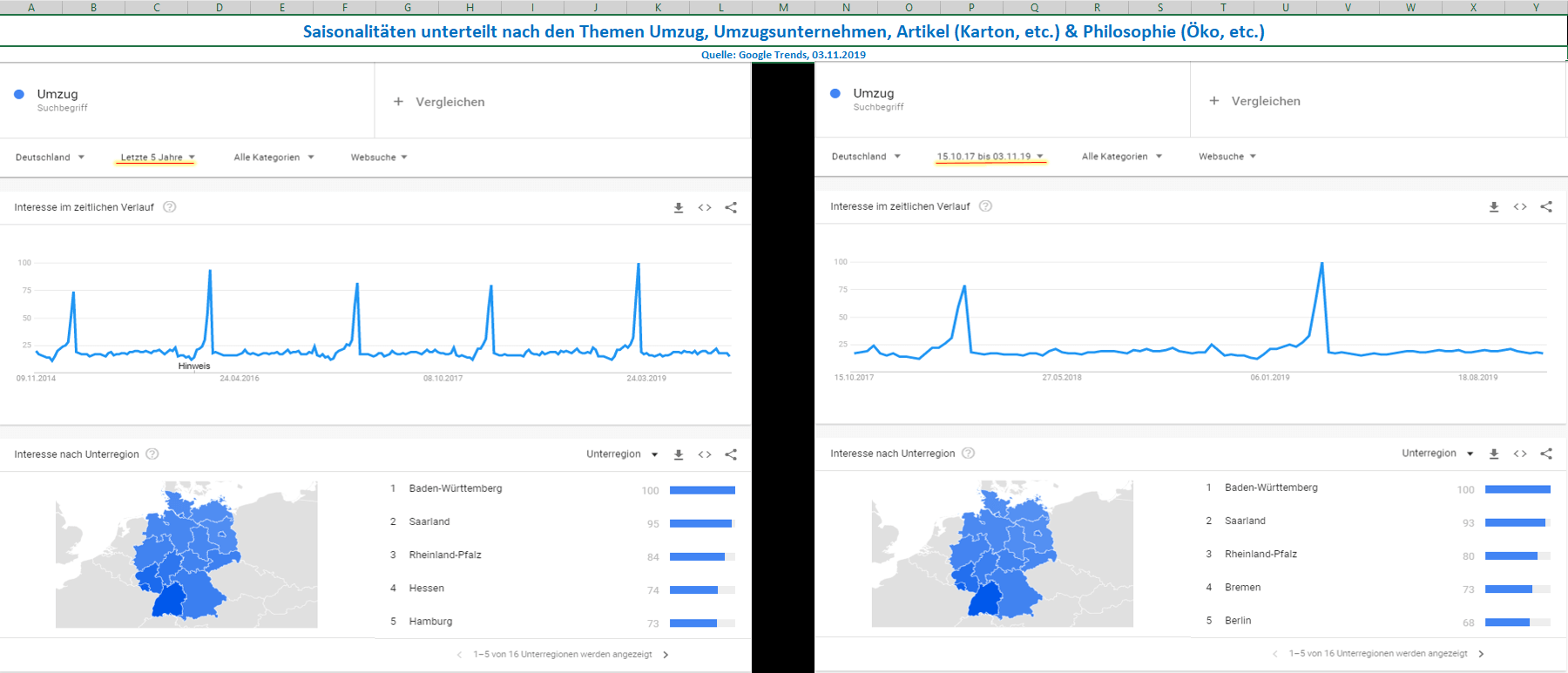

Google Trends & Google Correlate

Auch mit Google Trends und dem mittlerweile eingestellten Dienst Google Correlate, konnte ich einige Erfahrung sammeln. Um Saisonalitäten zur Nachfrage der Produkte oder Dienstleistungen zu erkennen, eignet sich dieses Tool hervorragend. Doch auch um Hypothesen zu zwei miteinander korrelierenden Begriffen vorab zu prüfen, ist dies ein praktisches Werkzeug. Auf diese Weise können Navigationspunkte, Cross-Selling oder auch die optimalen Zeiten für den Einsatz des Google-Ads Budgets verbessert werden.

Screaming Frog

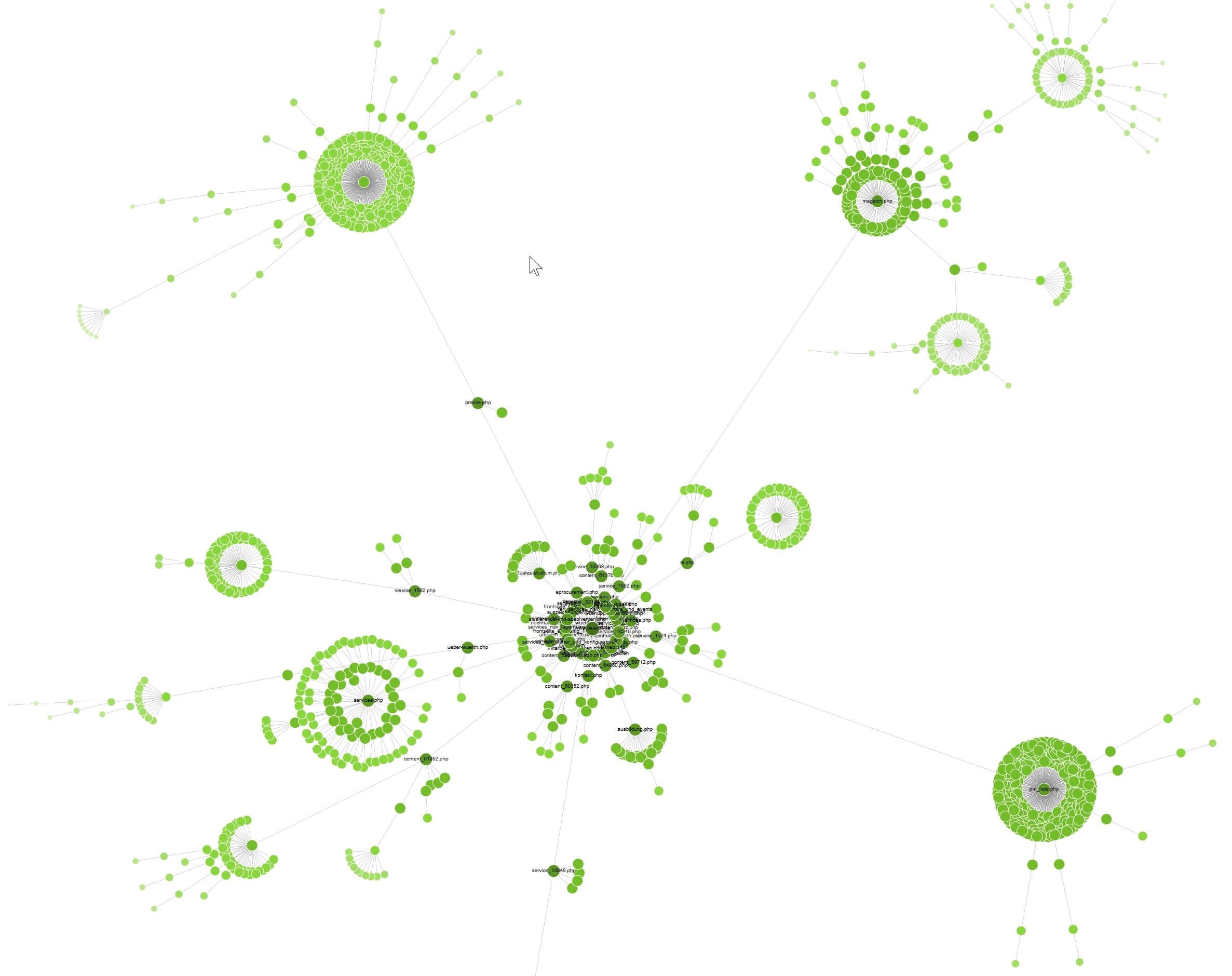

Neben dem bekannten PageRank existiert auch der sogenannte CheiRank, welcher Seiten mit guten Zentralitätsmaßen höher gewichtet, als jene mit langen Klickpfaden. Um diese Pfade auf einen Blick abbilden zu können, eignet sich Screaming Frog sehr gut. In dieser Abbildung kann man sehr gut erkennen, wie sich die Klicktiefe einer großen Website verteilt.

Gephi

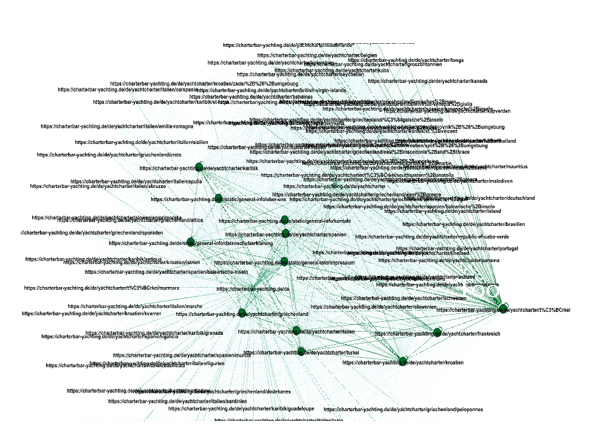

Durch Backlinks, aber auch interne Verlinkungen, erhalten Seiten einen sogenannten PageRank von Google. Diesen Wert kann man durch gezielte interne Verlinkung an Seiten weitergeben. Hier spricht man von sogenanntem Linkjuice, der auf der Website verteilt wird. Um Hub-Seiten zu stärken oder den PR von unerwünscht starken Seiten (z.B. Impressum) auf gewollt starke Seiten weiterzuleiten, eignet sich eine Visualisierung mit Gephi sehr gut. Auch dies war ein Teil meiner Aufgaben im Rahmen der ersten Vertiefung des Studiums.

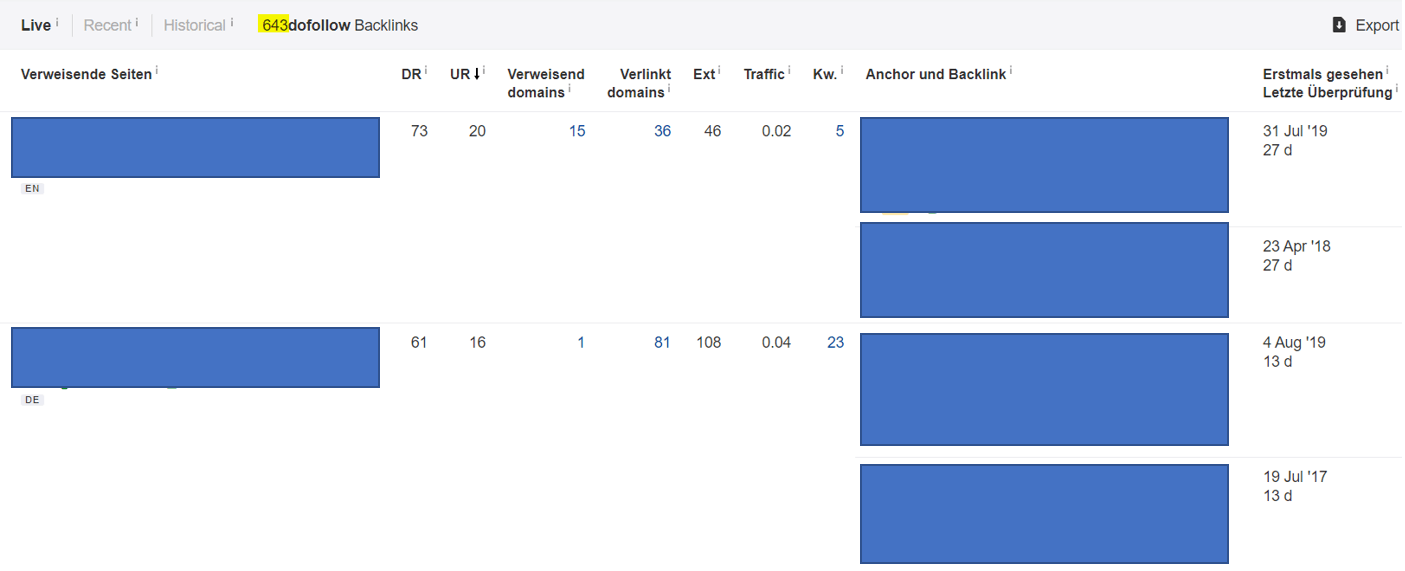

Ahrefs

Besonders für Machbarkeitsanalysen zu Kundenberatungen ist es sinnvoll die Wettbewerber auf ihr Backlinkprofil zu Benchmarken. So ist schnell ersichtlich, wie groß der Aufwand wird, mit dem organischen Ranking in der SERP mithalten zu wollen. Besonders zuverlässig und empfehlenswert ist hierzu Ahrefs. Auch hiermit konnte ich im Rahmen meiner Seminararbeit Erfahrungen sammeln.

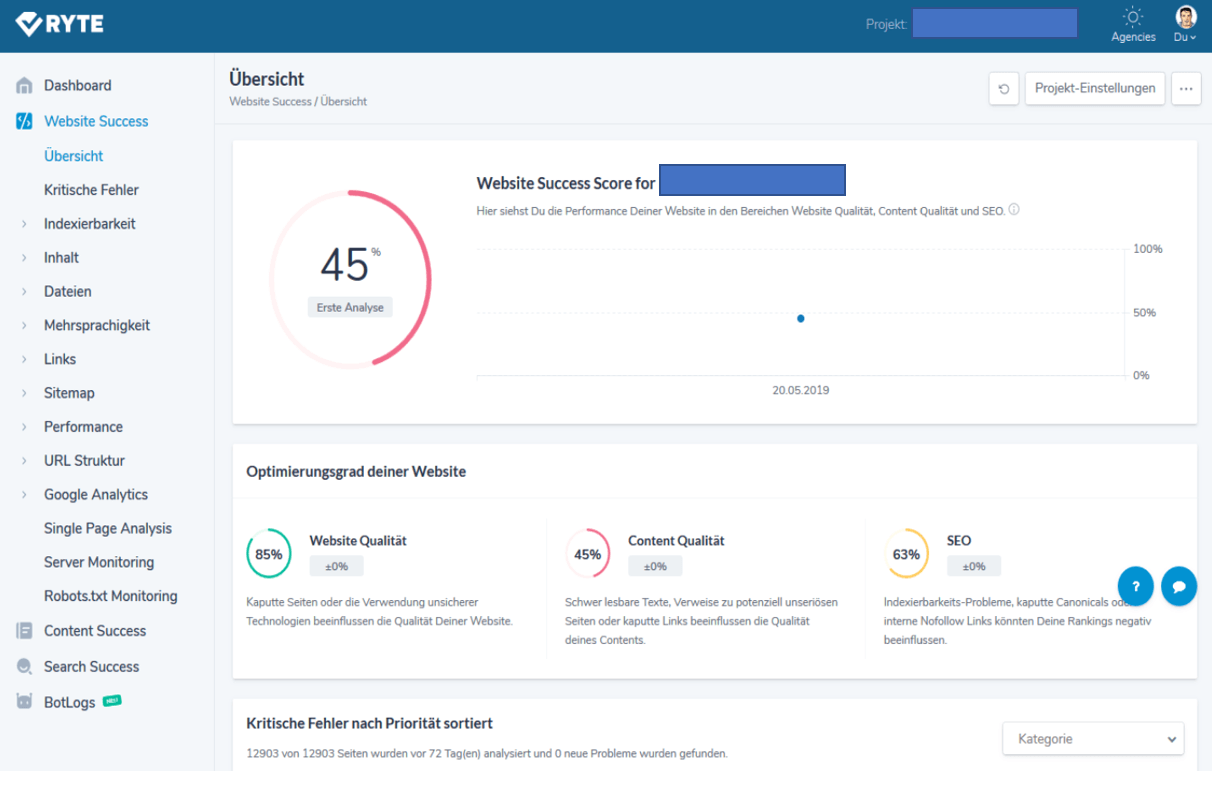

Ryte

Die Grundlagen, um erfolgreiches SEO zu betreiben, ist eine bestehende ordentliche Website-Hygiene. Um diese Performance einer Website umfassend zu prüfen und gezielt Maßnahmen ergreifen zu können, eignet sich Ryte hervorragend. Mit diesem Tool konnte ich während unserer Projektarbeit erste Erfahrungen sammeln und Maßnahmen, wie das Anfertigen von nötigen 301-Redirects, ergreifen.

Betreuung des Online Shops in Shopware 5

Während meiner Zeit im Marketplaces Management, umfasste mein Aufgabenbereich zudem die Betreuung des sowohl Unternehmenseigenen Online Shops, als auch Online Shops einiger Kunden. Hier umfassten meine Tätigkeiten:

- die zentralisierte Stammdatenpflege in CSV-Dateien und deren Importe bei Erweiterungen der Produktpalette,

- die Optimierung und Einpflege von Produktbildern,

- das Erstellen von Product-Streams,

- die Anfertigung von 301-Redirects,

- das Erstellen von Multivarianten,

- die Einpflege von Google Shopping Kategorien

- und Vorschläge Ausarbeiten zur Conversion-Rate Optimierung (Siegel, Zertifikate, Checkout-Optimierungen)

Praxiserfahrung mit Projektmanagement Software

Podio Projektmanagement-Software

In meiner Zeit als Praktikant in einer Online-Marketing Agentur, habe ich über ein halbes Jahr hinweg gelernt, mit Podio in Teams zu arbeiten und sowohl Tasks, als auch Terminkalender strukturiert zu planen und abzuarbeiten.JIRA Projektmanagement-Software

In meiner Zeit als Werksstudent bei einer Agentur für Webdesign und Online-Marketing, habe ich anschließend auch JIRA und Confluence als bewährte Projektmanagement-Software kennengelernt und für die Planung und Bearbeitung von Projekten in Teams genutzt.

Trello Projektmanagement-Software

Zur Planung und Bearbeitung von unterschiedlichen Aufgaben in Studienprojekten der FH, hat unsere Gruppe sich für Trello entschieden und auch dies erfolgreich genutzt, um koordiniert den Projekterfolg zu gewährleisten.